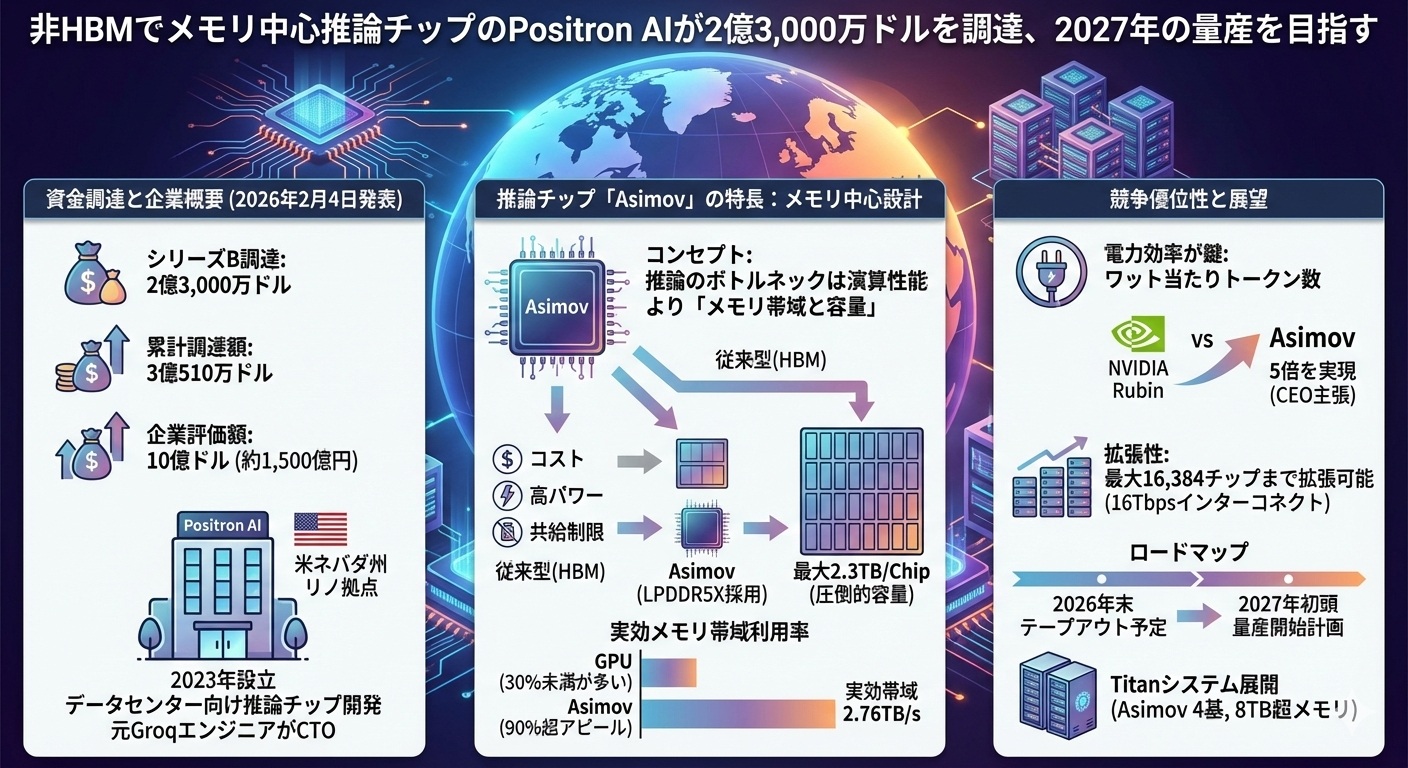

非HBMでメモリ中心推論チップのPositron AIが2億3,000万ドルを調達、2027年の量産を目指す

2026年2月4日、データセンター向け推論チップを手がける半導体スタートアップ米Positron AIは、資金調達シリーズBで2億3,000万ドルを調達したと発表した。

Positron AIは2023年設立のAIチップ・スタートアップで、ネバダ州リノに本拠を置く。元GroqのエンジニアがCTOを務め、社員数は推定50名程度。現在同社はGroqと競合するデータセンター向け推論チップ「Asimov」を開発している。

今回の資金調達により、Positron AIの累計調達額は3億510万ドル、企業評価額は10億ドル(約1,500億円)に達した。

Positron AIが開発する「Asimov」の特長は、HBMではなくLPDDR5Xを活用している点にある。その背景には、Transformer推論のボトルネックを演算性能ではなくメモリ帯域とメモリ容量だと明確に定義し、そこから逆算してチップを設計する「メモリ中心」の思想がある。

「Asimov」の公開仕様では、最大2.3TB/Chipのメモリ容量、実効メモリ帯域2.76TB/sを掲げ、さらに「実ワークロードで帯域利用率90%超」と強くアピールしている(GPUでは帯域利用率30%未満が多いとされる)。NVIDIAが発表している次世代GPU「Rubin」のメモリ容量が384GBであることを踏まえると、最大2.3TBという「Asimov」のメモリ容量は圧倒的と言える。

Positron AIがHBMを使わない理由は、コストと消費電力の負担、さらには供給面の制約の大きさといった運用課題を回避するためだ。LPDDR5Xを前提に実効帯域を稼ぐ設計で、同等の実効帯域と大容量を狙うというのが同社の考えである。

AIの運用コストを左右するのは演算速度よりも「電力効率」だと考えると、いかに少ない電力で多くの出力を得るかが重要になる。PositronのCEOであるMitesh Agrawal氏は、「Asimov」が主要なAIワークロードにおいて、NVIDIA Rubinの5倍の「ワット当たりトークン数」を実現すると主張している。

なお「Asimov」はGroqの推論チップのように、大容量メモリを前提としたパイプライン化により効率的な推論処理を実現するほか、複数チップによるスケールアップを前提に16Tbpsのチップ間インターコネクトを採用。「Asimov」は、最大16,384チップまで拡張できるという。

昨今、推論チップへの大型投資が相次いでいるが、メモリ中心の思想を掲げつつHBMを使わない推論チップという独自のポジションを取るPositron AIは、一見すると異質な存在に見える。しかし同社は、すでにHBMを使用している現行の推論システムでビジネス面の実績があり、既存ソリューションの延長線上にある「Asimov」という実現性の高いロードマップが、今回の資金調達成功につながったようだ。

Positron AIは2026年末に「Asimov」のテープアウトを予定しており、2027年初頭からの量産開始を計画中。4個の「Asimov」を搭載し、8TB以上のメモリを備えた「Titanシステム」を展開することで、推論市場における独自カテゴリーの確立を狙っている。

Positron AI

= EDA EXPRESS 菰田 浩 =

(2026.02.09

NEW

)